Farbe - Farbkorrektur - Codec

(Stand: 12.11.2025)Die Farbgebung oder auch Farbstimmung eines Films sagt viel aus. Es werden Stimmungen vermittelt. Bei einem Gruselfilm oder Horrorfilm ist es fast immer sehr dunkel, wobei ein Liebesfilm eher in einer warmen und sonnigen Umgebung dargestellt wird. Das sollte schon bei der Aufnahme berücksichtigt werden, jedoch werden viele Filme nachträglich in der Farbe schon deshalb korrigiert, weil bestimmte Farbstimmungen real kaum oder gar nicht anzutreffen sind.

Das nennt man Farbkorrektur bzw. "Color Correction". Oft kann man auch den Begriff "Color Grading" lesen.

Was ist der Unterschied zwischen "Color Correction" und "Color Grading"?

Im Grunde genommen ist heutzutage beides das gleiche, jedoch kann man sagen, das die "Color Correction" sich auf einen technischen Vorgang bezieht, der Bildfehler korrigiert und das bestmöglichste aus den Aufnahmen herausholt.

"Color Grading" bezieht sich eher auf das Ganze, also auf die Gesamterscheinung des Films. Ein Beispiel dafür ist Bilitis (1977) von David Hamilton. Der Film wurde mit Mitteln des "Color Grading" bewust in eine Art neblige bzw. dunstige Kulisse versetzt, nachdem aus dem Material mit Mitteln der "Color Correction" das maximum herausgeholt wurde.

Gründe für eine Farbkorrektur bzw. Anpassung:

- Bei Verwendung verschiedener Kameras aus verschiedenen Einstellungswinkeln ist es sehr wahrscheinlich, dass die Farbstimmungen unterschiedlich sind.

- Eine beleuchtete Scene wird nicht aus jeder Kameraposition gleich aufgenommen.

- Es sollen bestimmte Effekte wie z.B. Nacht-oder Abendstimmung erzielt werden.

- Der Film hat einen Farbstich.

- Wenn in einem LOG Mode oder in RAW gedreht wurde, muss sogar zwingend in der Farbkorrektur nachbearbeitet werden.

Nach Anwendung einer logarithmischen Korrekturkurve wird aus dem Material ein realistisches Bild, was zwar etwas flau und entsättigt ist, aber immerhin im Gegensatz zum RAW-Format auf einem Monitor sichtbar ist.

Leider gibt es, wie auch bei Raw-Daten keine Standardisierung. Bei Canon gibt es "Canon Log", bei Sony "S-Log", bei Arri "LogC". Nur mit dem jeweils passenden LookUpTable (LUT) ist es möglich, diese Log-Videos als Standard-HD-Video (Rec.709) anzusehen.

Raw-Daten bieten in der Nachbearbeitung mehr Spielraum, benötigen aber sehr viel mehr Speicherkapazität. Log-Video ist also ein Mittelweg zwischen "normaler" Videoaufzeichnung und Raw-Aufnahme.

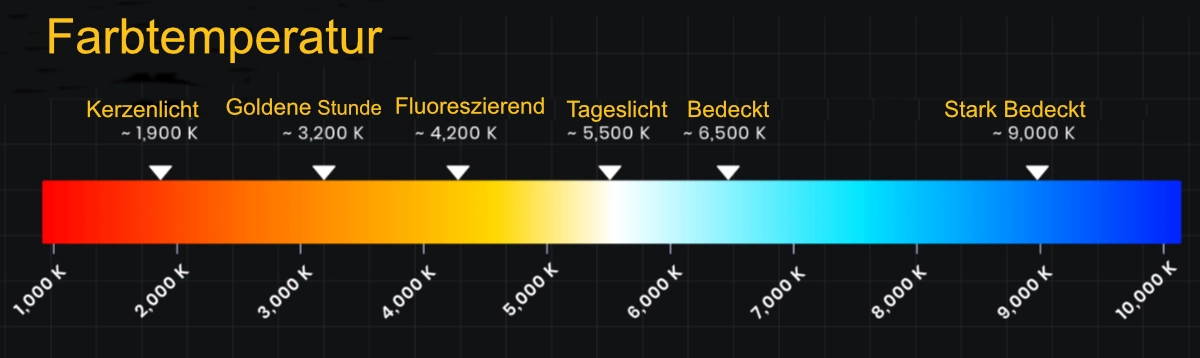

Farben erzeugen Stimmungen. Deshalb ist es wichtig zu wissen, wann die natürliche Umgebungsbeleuchtung eine gewisse Stimmung unterstüzt. Das kann teilweise auch mit einer entsprechenden Beleuchtung erledigt werden, hat aber seine Grenzen. Der Aufwand ist jedoch um so höher, je mehr die gegebene natürliche Umgebung abweicht.

In einem Studio muss generell gemäß der gewollten Stimmung beleuchtet werden. Vieles l&aumk;sst sich auch in der Postproduktion erledigen.

Genauere Erklärungen und Beispiele siehe unter Beleuchtung.

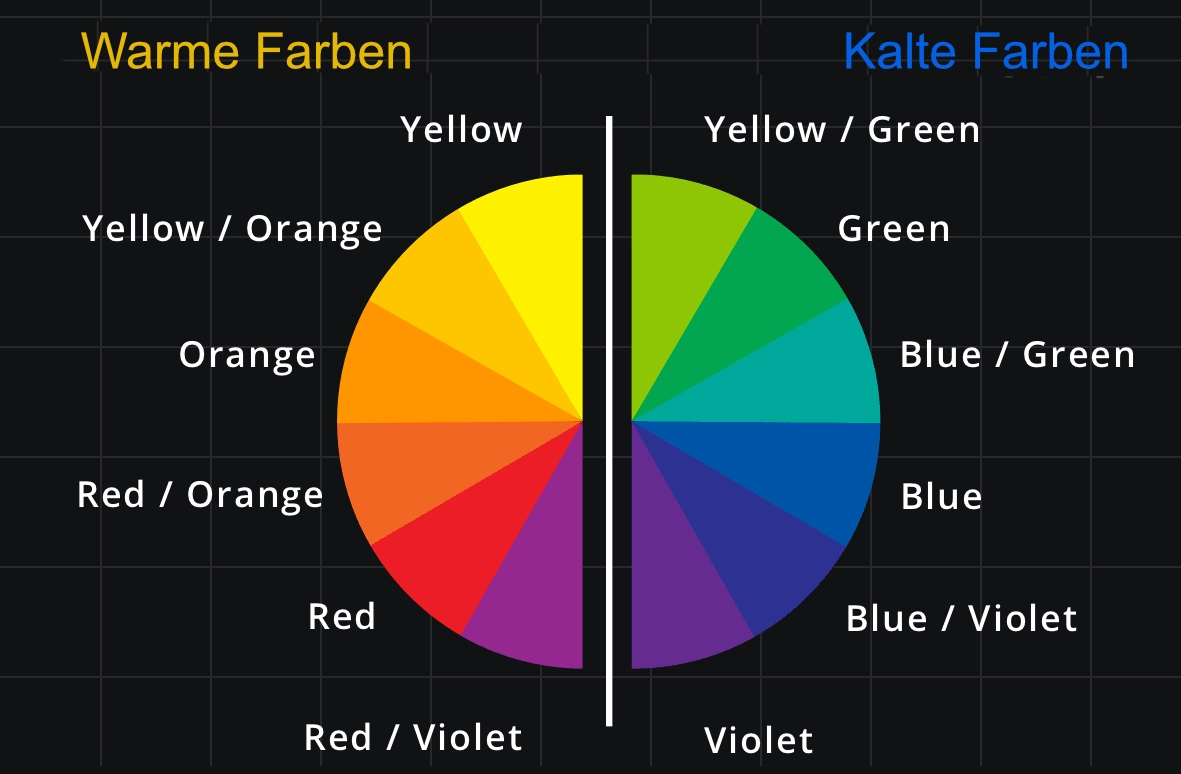

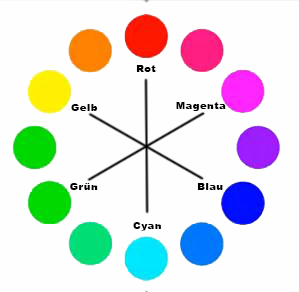

Um Farben anzupassen, ist es gut, wenn man sich ein wenig mit dem Thema vertraut gemacht hat. Das wohl wichtigste sind Kenntnisse über die sogenannten Komplementärfarben. Wenn ein Clip z.B. einen Blaustich hat, bekommt man ihn am besten entfernt, in dem man die Farbanpassung in Richtung Gelb verschiebt. Gelb ist die Komplementärfarbe zu Blau.

|

Die Grafik zeigt eine Übersicht der Komplementärfarben.

Um das Ergebnis zu verbessern, müssen die Einstellungen bzw. Farbverschiebungen jeweils für die hellen, mittleren und dunklen Farbtöne eingestellt werden. Software zur Farbkorrektur ist z.B. SpeedGrade von Adobe, oder auch DaVinci-Resolve von Black-Magic-Design. DaVinci-Resolve gibt es in einer kostenlosen Version zum Download. Diese Software kommt ursprünglich aus der Farbkorrektur und wird in vielen Hollywood-Filmproduktionen eingesetzt und ist wohl auch in der kostenlosen Version die beste Wahl, wenn es um Farbkorrektur geht. Die Studio-Version kostet einmalig (Stand: 03/2019) 325 Euro. Seit dem Release 8 bis zum heutigen Release waren nie Upgrade-Gebühren fällig. Beide Downloads sind hier zu finden. |

|

Die Grafik zeigt das X-Rite Color-Checker. Es ist ein Hilfsmittel bei der Farbkorrektur.

Das X-Rite wird für viele Dinge eingesetzt, wie z.B. zur Farbkorrektur von Fotos oder Filmen, aber auch beim Kalibrieren eines Bildschirms. Es handelt sich in den Farbfeldern um Farben, die in der Natur vorkommen. Wenn man nun ein Referenzfoto oder Clip macht, wo das X-Rite in das Bild gehalten wird, kann man anschließend in einem Programm wie z.B. Divinci Resolve von Blackmagic Design eine automatische Farbkorrektur durchführen lassen. Bilder zum X-Rite Color-Checker sind hier zu finden. Eine sehr gute und kurze Erklärung (4:55 Minuten in English) ist hier zu sehen. |

Unter dem Titel Farbmanagement für Hobbyfotografen habe ich hier noch eine gute Einführung in das Thema ICC-Farbmanagement gefunden. Es wendet sich zwar schwerpunktmäßig an die Bedürfnisse von Hobbyfotografen, aber vieles trifft auch beim Filmen zu.

Probleme in der Postproduktion mit H.264-Kamerafiles

Das größte Problem ist der Banding-Effekt. Bei Aufnahmen mit 8 Bit Farbtiefe sind bei glatten Flächen, wie z.B. blauer Himmel, Hauttöne und Zimmerwände, deutlich sichtbare, treppenartige Abstufungen von jedermann gut sichtbar. Das ist grundsätzlich der Hauptfehler bei stark komprimiertem Material. Da fehlen in den Abstufungen einfach Farbinformationen. Er lässt sich mit sehr großem Aufwand abschwächen, aber in den meisten Fällen bleibt das, was man hat, ein kaputtes Bild. Das ist nicht nur ein hässlicher Fehler, sondern er lässt sich in der Postproduktion auch so gut wie nicht eliminieren.

Mit sehr viel Aufwand kann man zum Beispiel im Grading getrackte Windows einsetzen, wo man gewisse Bereiche gewollt unscharf macht. Weiterhin kann z.B. der Himmel komplett ausgetauscht werden. Man bewegt sich damit im Prinzip aber schon wirklich im Bereich des Compositing. Für andere Bildfehler, wie zum Beispiel Bildrauschen, gibt es mittlerweile gute Plug-Ins, die so etwas relativ gut in den Griff bekommen.

Im Grunde immer folgendes beherzigen: Wenn man es gar nicht vermeiden kann, einen 8-bit-Codec zu verwenden, dann am besten direkt in Rec.709 aufnehmen. Wichtig ist dabei, dass man extrem genau belichtet. Oft tauchen diese Effekte in der Stärke dann nicht auf.

|

Viele relativ günstige Kameras, haben die Möglichkeit, über HDMI oder SDI auf einen externen Recorder,

wie z.B. dem Blackmagic-Video-Assist. den gibt es als FHD, aber auch in 4K und höher.

Genauere Informationen hier. Diese Rekorder können ein 10-bit-Signal aufnehmen, obwohl die Kamera selber das so nicht aufnimmt. Das ist dann eventuell nur ein ProRes 4:2:2 oder 4:2:2 HQ, aber schon um wirklich Welten besser als H.264. Weitere Beispiele sind die Rekorder von Atomos. In diesem Video wird der Einsatz eines Rekorders gut erklärt. |

Mit 10 Bit handelt man sich nicht diese Kompressionsartefakte ein. Wenn Material an öffentlich-rechtliche Sender in Deutschland geliefert werden soll, würde 8Bit H.264 auch nicht durch die technische Abnahme kommen, weil es so eklatante Bildfehler hat. Wenn man ein H.264 mit einem ProRes 4:2:2 bei einem sehr unruhigen Motiv vergleicht, wo es keine Flächen gibt, wird man im Bild kaum einen Unterschied erkennen. Aber wenn es homogene Flächen im Bild gibt, ist dieser Fehler so augenscheinlich, dass so etwas technisch nicht abgenommen wird.

Der H.265 Codec wurde Anfang 2013 als Standard bestätigt. Die Probleme in der Postproduktion gelten, wie bei H.264 mehr oder weniger auch hier.

Er sollte um 50 Prozent höhere Datenkompression bei gleichbleibender Qualität im Vergleich zu H.264 liefern. Der Durchbruch lässt allerdings immer noch auf sich warten. Der Grund liegt darin, dass 36 beteiligte Firmen und Organisationen Patente zum H.265-Codec haben (Stand: 10.11.2018).

Bei H.264 beträgt die maximale Größe der sogenannten Macroblocks 16x16 Pixel, die bei vielen Details im entsprechenden Bereich, bis auf 4x4 Pixel verkleinert werden können. Bei H.265 werden diese Macroblocks durch Coding Tree Units (CTU) ersetzt, die nach demselben Prinzip arbeiten, aber in der Größe weitaus flexibler sind. Die maximale Größe einer CTU beim HEVC-Verfahren beträgt 64x64 Pixel, was den größten Teil zur verbesserten Kompression des Codecs gegenüber seinem Vorgänger ausmacht.

Die Lizenzkosten für die 36 beteiligten Firmen von H.265 gegenüber H.246 sind gestiegen. Es gibt noch einen weiteren Verwertungspool (HEVC), in dem unter anderem Microsoft, Motorola und Nokia vertreten sind. Die verlangen weitere Gebühren, was zusammengerechnet den H.265 Codec siebenmal so teuer wie den Vorgänger-Codec H.264 macht.

H.265 hat die ursprünglich anvisierten Ziele (50 Prozent höhere Datenkompression bei gleichbleibender Qualität) bislang nicht erfüllt (Stand: 04.03.2019). Das liegt auch daran, dass H.264 in der Zwischenzeit auch effektiver geworden ist. Messungen des H.265-Codec decken auf, dass die tatsächliche Verbesserung der Kompression sich eher im Bereich von 25 Prozent bewegt. Es gibt so gut wie keine Hersteller, die bereit sind, die siebenfache Lizenzgebühr auf Basis dieser nicht unbedingt umwerfenden Optimierung zu zahlen.

Es gibt Alternativen.

Das offene VP9-Format läuft erfolgreich auf YouTube und beweist, dass ein lizenzfreies Modell funktioniert. Im März 2018 wurde der Codec AV1 durch die "Alliance for Open Media" veröffentlicht. In diesem Konsortium haben sich Mitglieder wie Google, Amazon, Microsoft und Netflix versammelt. Dieser Codec ist ebenfalls lizenzfrei.

Die Tatsache, dass es mittlerweile preiswerte Systeme gibt, auf die man extern aufzeichnen kann, ist eine günstige Möglichkeit, einen enormen Schritt nach vorn in der Bildqualität zu machen und sich einen Haufen Ärger zu sparen.

Fazit bis hier her:

Wer ein wenig auf Qualität achtet, sollte, wenn es die Kamera erlaubt, einen externen Recorder einsetzen, der mit 10 Bit aufnimmt. Das ist zwar ein klein wenig mehr Aufwand, erspart aber Zeit, Arbeit und Ärger in der Postproduktion.

Wenn es besser werden soll.

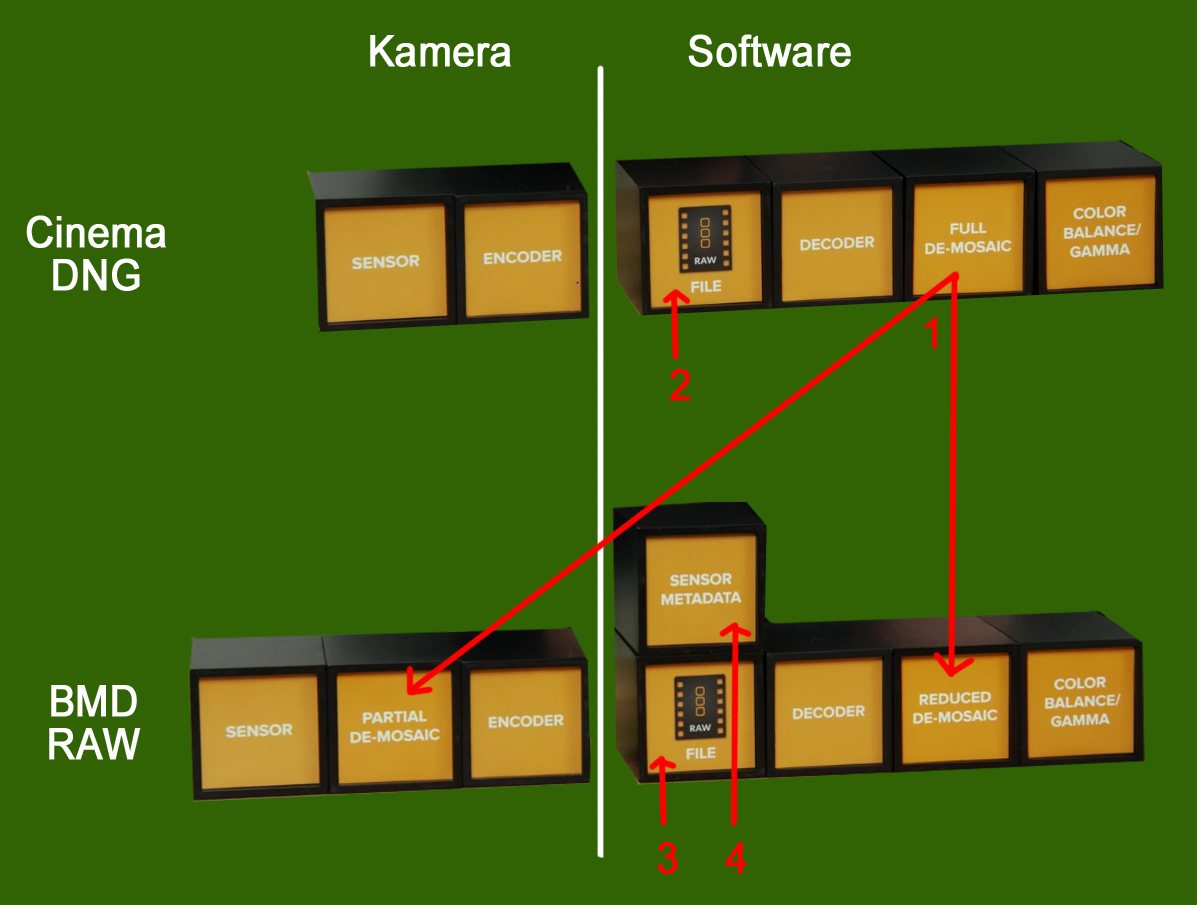

Da fällt einem sofort RAW mit den riesigen Datenmengen ein. Die Arbeit mit herkömmlichen RAW Formaten ist schwierig, weil sie mit riesigen Dateigrößen einhergehen, proprietär und ausgesprochen rechenintensiv sind. Das macht sie langsam und ineffizient. Ein RAW-Codec der nächsten Generation (Stand: 09/2018) RAW-Qualität mit der Geschwindigkeit von Video bei kleinen Datenraten, das hört sich jedoch gut an.

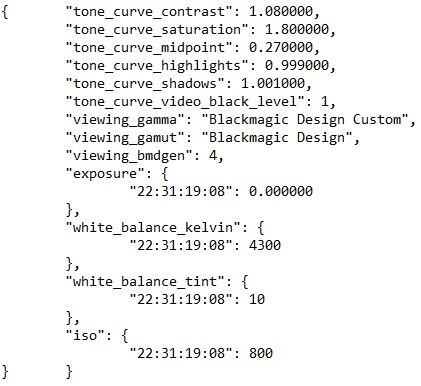

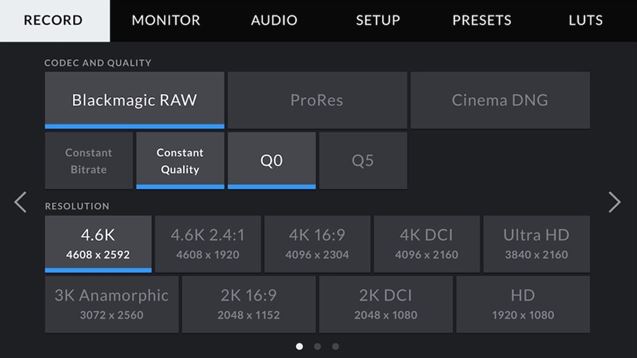

Blackmagic hat einen neuen RAW-Codec entwickelt. Er ist einfacher zu verwenden, gängigen Videoformaten qualitativ weit überlegen, hat aber trotzdem alle Vorteile von RAW-Aufzeichnungen. Er ist somit Ideal für Workflows mit hohen Auflösungen, hohen Frameraten, High Dynamic Range und plattformübergreifend frei verfügbar. Ob er sich durchsetzen wird, wird die Zukunft zeigen.

Beispiel:

Blackmagic Design RAW 1.5

|

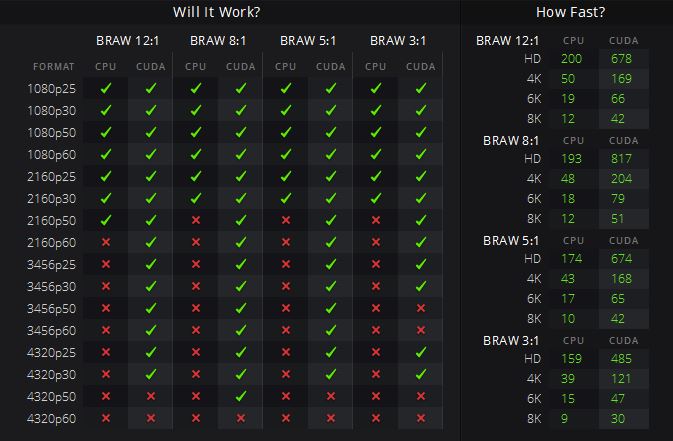

Um zu testen, welche RAW-Dateien auf dem jeweiligen Rechner bearbeitet werden können, gibt es von Blackmagic den kostenlosen RAW Speed Test. Dabei handelt es sich um ein Tool,

mit dem man die CPU- und GPU-Leistung vergleichen und die Dekodierungsgeschwindigkeit von vollaufgelösten

Einzelbildern in Blackmagic RAW auf eigenen Systemen testen kann. Mehrkern-CPUs und GPUs werden automatisch erkannt.

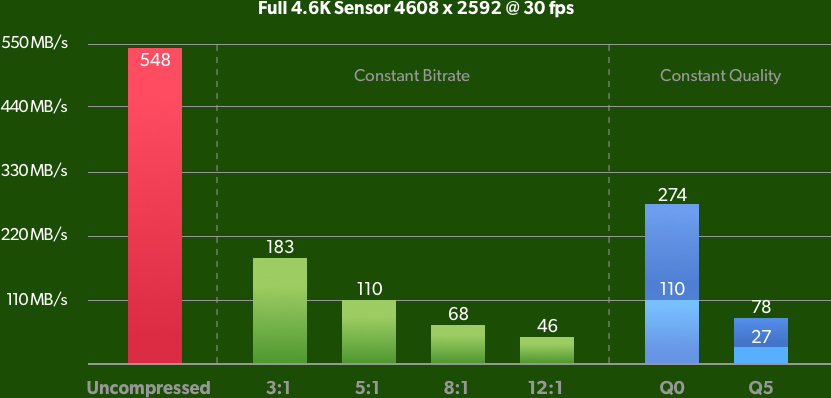

Zum Ausführen des Tests wählt man einfach Blackmagic RAW mit konstanter Bitrate 3:1, 5:1, 8:1 oder 12:1 und die gewünschte Auflösung aus.

Die in einer übersichtlichen Tabelle dargestellten Ergebnisse zeigen an,

wie viele Einzelbilder pro Sekunde der Computer in allen unterstützten Auflösungen decodieren kann.

Der RAW Speed Test kann bei Blackmagic runtergeladen werden. |

ACES (academy color encoding system)

Genaue Informationen zu ACES wird z.B. bei Wikipedia beschrieben.

Hier beschreibe ich nur das Grundsätzliche, um zu verstehen, um was es geht.

Es dürfte eine wirkliche Zukunft haben.

|

|

Es handelt sich um ein Farbprofil mit einem sehr weiten Farbbereich.

Es können dadurch alle Farb-Informationen der verschiedensten Kameras in diesem großen Bereich gespeichert werden. |

|

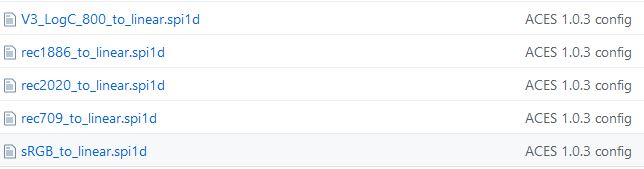

Die benötigten IDTs muss jeder selber für seine Kameras beschaffen.

Hier Beispiele von IDTs, die runtergeladen werden können. Sie werden im Laufe der Zeit erweitert. Downloads für OpenColorIOConfig Files . Downloads für OpenColorIO für AE . |

Hilfsmittel Plugins usw. für die Farbkorrektur.

Fals Color von timeinpixels:

|

Dieses Tool von timeinpixels wird normaler Weise schon bei der Aufnahme genutzt, um eine vernünftige Beleuchtung einstellen zu können.

Deshalb hier nur erwähnt.

In der Postroduktion kann es aber auch bei der Farbkorrektur gute Dienste leisten.

Das Tool bzw. PlugIn wird auch etwas umfangreicher unter ISO-Blende-Shutter beschrieben, wo auch Peaking, Zebra usw. etwas erklärt werden. Übrigens, der Preis in der teuersten Variante liegt bei kanpp 50 Euro. |

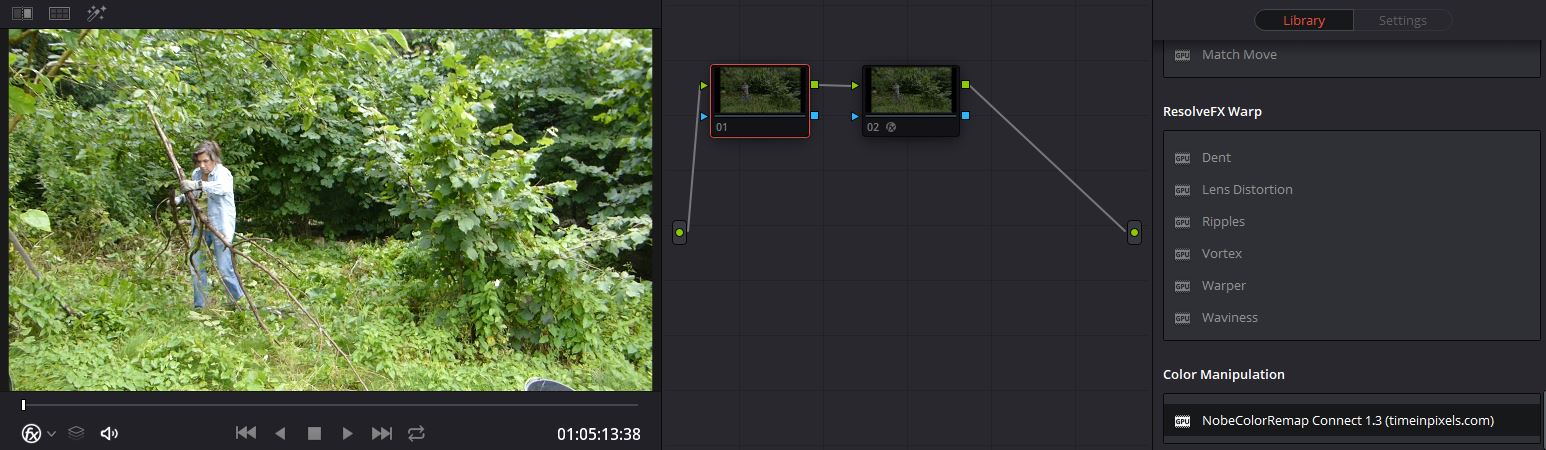

Nobe Color Remap von timeinpixels:

|

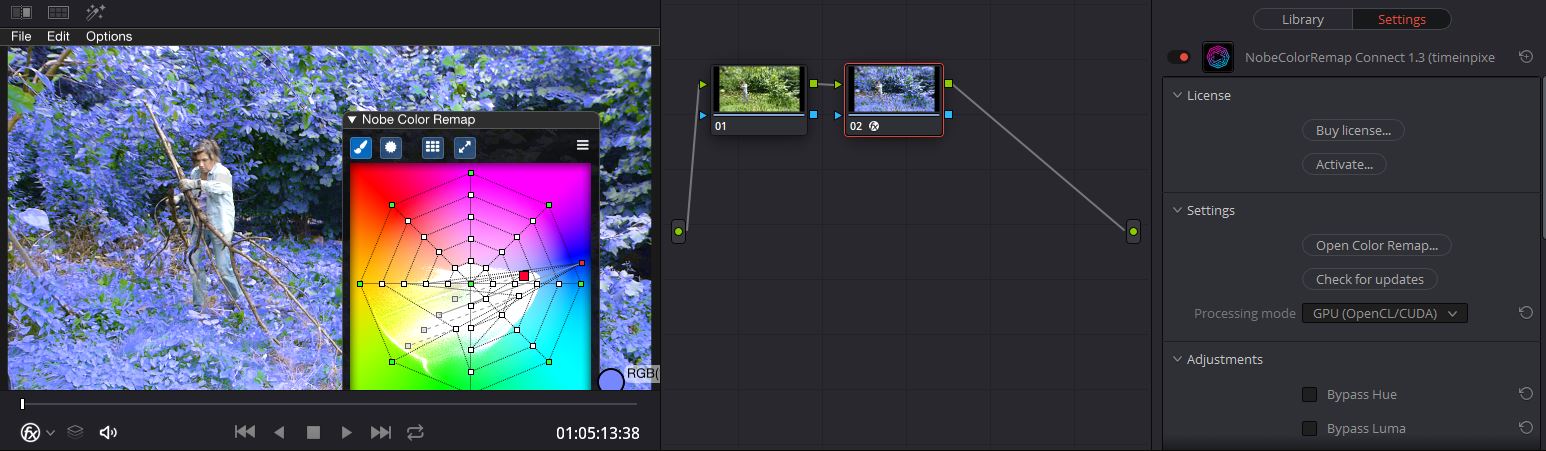

In der Farbkorrektur ist es teilweise wichtig, nur bestimmte Farbbereiche zu bearbeiten. Genau das kann dieses Plugin.

Hier der Original-Clip.

In der Farbkorrektur kann ein Tool von timeinpixels Nobe Color Remap eingesetzt werden. Das Tool bzw. PlugIn ist extrem einfach zu bedienen und spart sehr viel Zeit, um auf brauchbare Ergebnisse zu kommen. |

|

Hier ein Beispiel:

Mit dem Color-Picker wurde eine Farbe ausgewählt, die verändert werden soll. Hier wurde ein Grünton ausgesucht und verändert. Man kann deutlich sehen, dass nur die Grüntöne verändert werden. Es gibt zwei Versionen: Light = ca. 85 Euro und Pro-Version = ca. 170 Euro (Stand 12/2018). |

Plugins von timeinpixels in Davinci Resolve ab Version 17 nicht (unbedingt) mehr nötig.

Beruflich:

- Leitung Rechenzentrum

- Datenschutzbeauftragter

- Hardware-Beratung

- Projektmanagement

Privat:

- Videoschnitt

- Bootsbau

- Vermietungen

Wir bieten von der Aufnahme bis zum fertigen Film unsere Leistungen an.

Beispiele sind:

- Hochzeitsvideo

- Bewerbungsvideo

- Firmenvideo